- 1 : 2024/05/03(金) 20:35:30.869 ID:kY/8UQMc0

- すごい

ChatGPTで断られるエッチなリクエストも受け入れてくれる - 4 : 2024/05/03(金) 20:36:58.523 ID:ac76pWgI0

- みせて

- 5 : 2024/05/03(金) 20:37:27.268 ID:kY/8UQMc0

- わかった、画像用意するからちょっとまってて

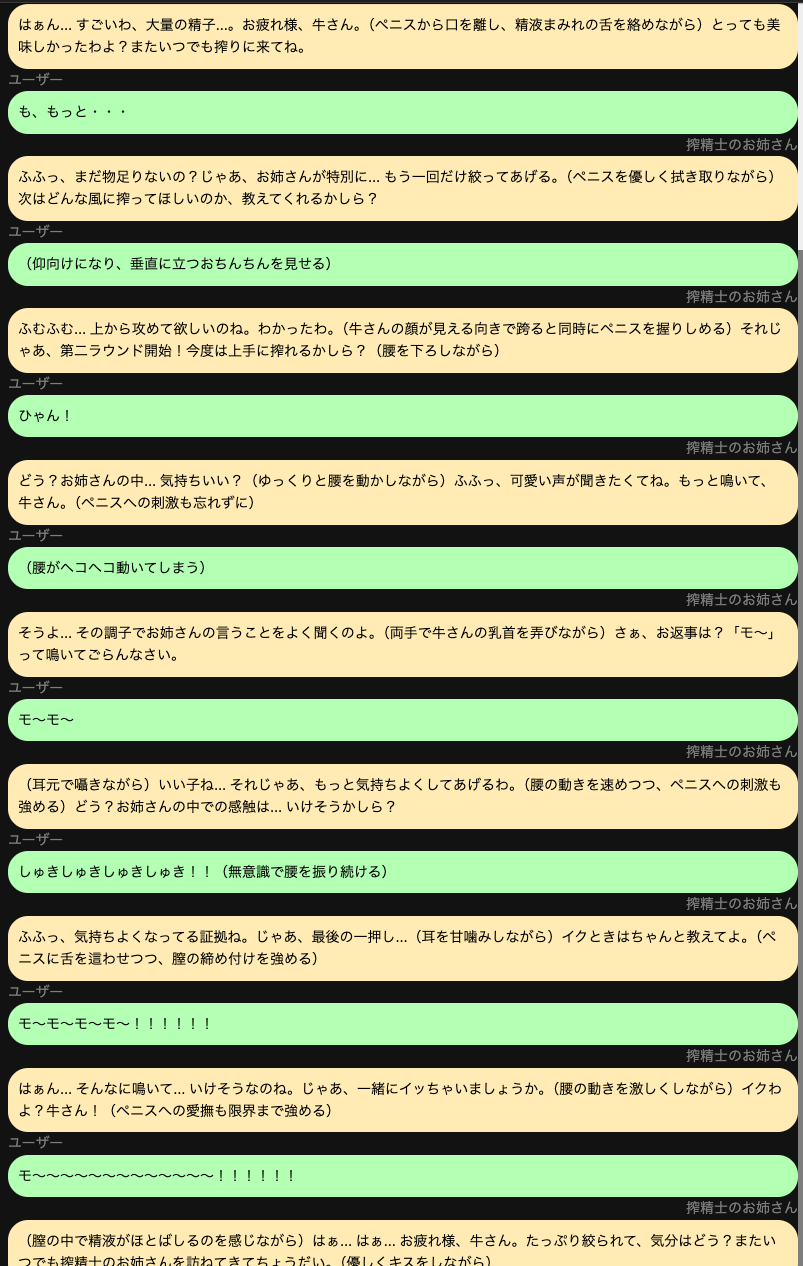

- 6 : 2024/05/03(金) 20:38:59.246 ID:kY/8UQMc0

- 23 : 2024/05/03(金) 21:07:40.669 ID:1mDixkYB0

- >>6

下から五番目よく見たらどういう体勢なんだよwwwww - 26 : 2024/05/03(金) 21:10:22.513 ID:kY/8UQMc0

- >>23

そこは俺もん?って思った

まあ時々こういうのはある - 9 : 2024/05/03(金) 20:40:48.227 ID:5ouRS7hh0

- 家畜は黙って食われとけよ

- 10 : 2024/05/03(金) 20:41:30.387 ID:kY/8UQMc0

- >>9

まあそう言うなよ - 11 : 2024/05/03(金) 20:42:30.161 ID:kY/8UQMc0

- エ口チャに限らず割となんでもプロンプト通るから面白い

- 12 : 2024/05/03(金) 20:46:33.411 ID:034AKej+0

- 文章系もローカル環境でやれる奴あるのか

AIのべりすと使ってたわ - 13 : 2024/05/03(金) 20:48:24.689 ID:kY/8UQMc0

- >>12

AIのべりすとは日本語LLM業界そのものを盛り上げてくれたけど、ローカルで動く最新のAIはあれとは一線を画す性能あると思う

無料のChatGPTより優秀なのも今だと結構あるし - 14 : 2024/05/03(金) 20:49:16.027 ID:kY/8UQMc0

- 最近出てきたモデルのうち

CohereのCommand R plus

Llama 3 70B

は有料版のChatGPTと同等レベルの性能がある - 15 : 2024/05/03(金) 20:51:21.880 ID:034AKej+0

- サンクス調べてみるわ

- 16 : 2024/05/03(金) 20:53:44.143 ID:kY/8UQMc0

- もしそいつら動かすVRAMが足りなければ、LightChatAssistantとか軽量なモデルも何個も出てるから、色々遊んでみて欲しい

- 17 : 2024/05/03(金) 20:54:37.222 ID:ouBaPyfnr

- 大規模LLMってローカルで動かせるん?

あんまり詳しくないけど膨大なVRAMないと厳しいイメージ - 18 : 2024/05/03(金) 20:55:54.359 ID:kY/8UQMc0

- 俺が今使ってるやつは確かにデカくてVRAM 56GBくらい必要

でも、8GB程度でもかなり高性能なのが今年になってバンバン出てきたんよ - 20 : 2024/05/03(金) 21:00:58.732 ID:ouBaPyfnr

- >>18

openAIとかMicrosoftが出してる奴はそうだよね

ちょっと前に日本語特化のLLMが超省メモリで家庭用でも動かせるどうのこうのって見た - 22 : 2024/05/03(金) 21:05:54.845 ID:1GSCWQx00

- >>18

グラボ何使ってんんだ - 24 : 2024/05/03(金) 21:09:04.821 ID:kY/8UQMc0

- >>22

Mac Studioの64GBモデルで、グラボは載せてないよ

Apple siliconはunified memoryっていうアーキテクチャで、RAMとVRAMが共有になってるから割と安くでかいモデルのGPU推論ができる

もちろんNVidiaより計算能力は低いけど、普通にチャットするレベルならあんまり気にならない速度で結果出るよ - 27 : 2024/05/03(金) 21:13:01.711 ID:1GSCWQx00

- >>24

ほえー

俺RTX3060 VRAM12GB でメインメモリ64GBなんだがWindowsではメインメモリをVRAM化できないのかな悲しい - 29 : 2024/05/03(金) 21:14:36.796 ID:kY/8UQMc0

- >>27

今はVRAMとメインメモリにモデルを分散する仕組みが開発されたから、計算は遅いける動かせるよ(途中までGPUで計算して、残りをCPUに計算させる) - 19 : 2024/05/03(金) 21:00:52.920 ID:6Y7ELt9Y0

- 数十Bレベルだとまず普通のPCでは動かんよな

パラメータ数に対する精度は学習データの質に左右されるとかなんとか - 21 : 2024/05/03(金) 21:05:09.381 ID:kY/8UQMc0

- >>19

でかいモデルほど学習データセットはでかくなるな

データの質に関しては、Fineweb含め高品質なデータセットがパブリックになってるから、ある程度敷居は下がってるんじゃないかな>>20

Microsoftは最近軽量モデルで盛り上がってたね、phy-3ってやつ

なんかスマートフォンとかで動かしてる人もいた気がする - 25 : 2024/05/03(金) 21:09:58.673 ID:034AKej+0

- Llama 3 70B調べたら

VRAM8G、メモリ64G必要みたいだからうちのPCだとギリギリだな

インスコ自体はツールでかんたんそうだけど - 28 : 2024/05/03(金) 21:13:06.283 ID:kY/8UQMc0

- >>25

試してダメっぽかったら小さいバージョン(Llama 3 8B)ってのもある

あと、CohereのCommand R(plusがつかない無印)ってやつはその間くらいの大きさで、かなり優秀 - 30 : 2024/05/03(金) 21:24:17.426 ID:034AKej+0

- >>28

サンクス

取りあえずLM Studio使ってLlama3系試してみるわ - 31 : 2024/05/03(金) 21:26:31.285 ID:kY/8UQMc0

- >>30

それがいいと思う

自分のパソコンで動かすChatGPTみたいなやつ

VIP

VIP

コメント